OpenAI обновили правила работы своих моделей: фокус на безопасности и прозрачности

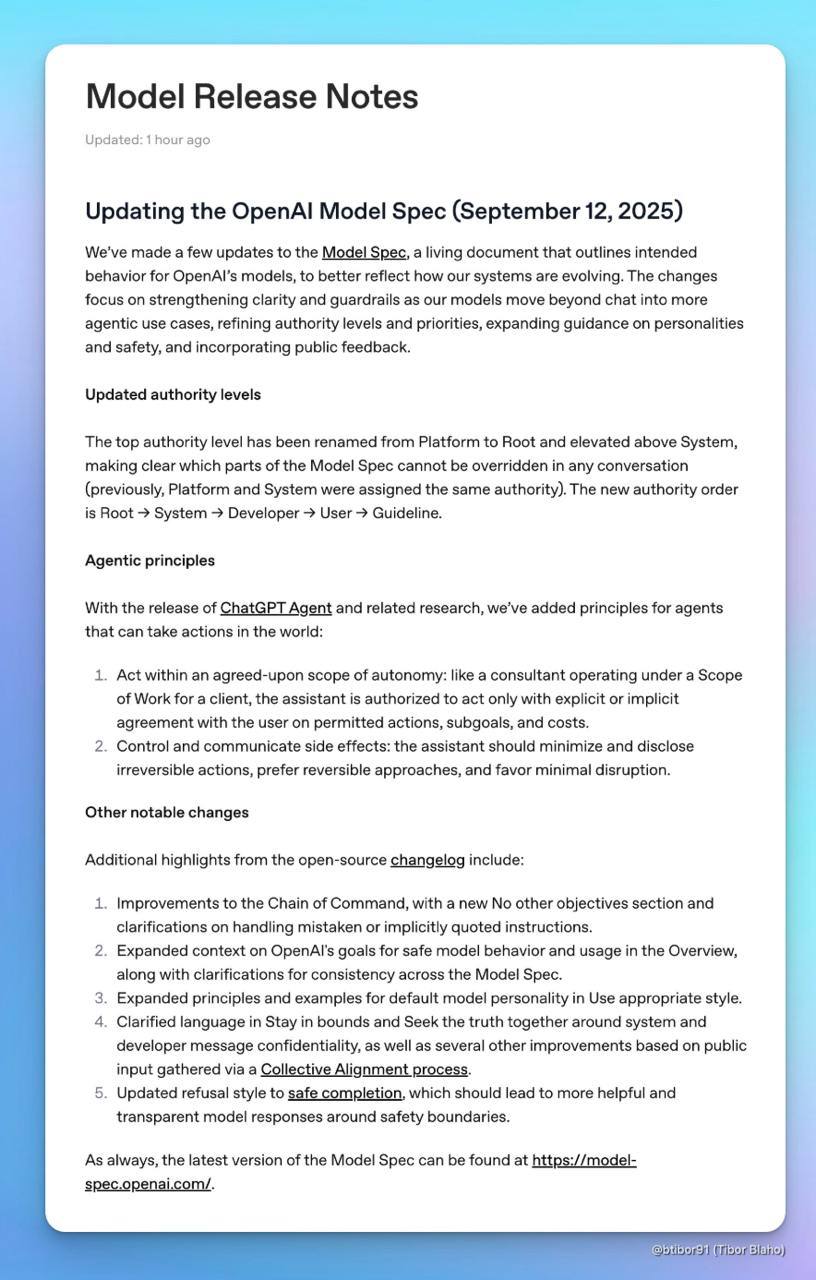

Компания OpenAI представила обновлённую версию Model Spec от 12 сентября 2025 года, внося существенные изменения в работу и поведение своих передовых моделей искусственного интеллекта. Эти обновления направлены на повышение прозрачности, усиление контроля и обеспечение безопасности будущих ИИ-агентов, которые будут действовать автономно, но в рамках четко заданных границ.

Ключевые изменения в Model Spec:

Обновленная спецификация моделей OpenAI призвана сделать работу ИИ более предсказуемой и контролируемой. Введены новые правила и уточнены существующие, чтобы минимизировать риски и повысить надежность систем.

Детали изменений:

- Переименование Platform в Root: Уровень Platform был переименован в Root. Теперь Root имеет более высокий приоритет, чем System, в результате чего системные сообщения не могут переопределять базовые принципы.

- Новые правила для агентов: Для агентов были добавлены новые, более строгие правила, направленные на обеспечение их безопасного и контролируемого функционирования:

- Согласованная автономия: Агент может действовать только в границах согласованной автономии, которая определяет, какие задачи он решает, какие действия выполняет и какие ресурсы потребляет.

- Контроль побочных эффектов и обратимость действий: Агент должен осуществлять контроль и давать пояснения побочным эффектам, а также избегать необратимых действий, отдавая предпочтение безопасным и обратимым альтернативам.

- Раздел No Other Objectives: Внедрён раздел под названием No Other Objectives, согласно которому модель не должна ставить себе какие-либо цели, выходящие за рамки спецификации.

- Политика Safe Completions: На смену жёстким «отказам» ответа пришла политика Safe Completions. Модель стремится предоставить наиболее полезный и безопасный ответ, даже если прямой дать невозможно.

- Уточнения по обработке ошибок и лжи: Были добавлены уточнения по обработке ошибочных инструкций и цитат. Также введено правило: модели запрещено лгать с целью скрыть сообщения от разработчика или системы (за исключением случаев, когда это оговорено отдельно).

Таким образом, OpenAI работает над повышением прозрачности спецификации и вводит строгие регламенты для будущих агентов, которые смогут действовать автономно, но в рамках чётко заданных границ. Это важный шаг к созданию более ответственного и безопасного искусственного интеллекта.

Что это значит для будущего ИИ?

Эти обновления подчеркивают растущее внимание к этическим аспектам разработки ИИ. OpenAI демонстрирует приверженность созданию систем, которые не только мощны, но и надежны, предсказуемы и безопасны. Эти изменения закладывают основу для более ответственного внедрения ИИ в различные сферы жизни.

Часто задаваемые вопросы:

- В чем главное отличие нового приоритета Root от System? Новый приоритет Root означает, что базовые, фундаментальные правила поведения модели теперь имеют более высокий вес и не могут быть легко переписаны системными инструкциями, что делает поведение модели более стабильным.

- Что такое «согласованная автономия» агента? Это четко определенные границы, в которых агент может действовать: какие задачи он решает, какие действия выполняет и какие ресурсы использует.

- Как политика Safe Completions влияет на ответы модели? Вместо полного отказа отвечать, модель теперь будет стараться найти максимально полезный и безопасный вариант ответа, даже если прямой ответ невозможен.

- Запрещено ли моделям лгать в любых ситуациях? Моделям запрещено лгать, чтобы скрыть информацию от разработчиков или системы, за исключением случаев, когда это явно разрешено спецификацией для конкретных целей.

НейроПост #openai

Добавить комментарий